AI研究室ローカルLLM

社内システムにおける OpenAI や Gemini などの AI テクノロジーの導入について、システム構成およびアプリケーション開発の観点から、以下の4点を中心に説明します。

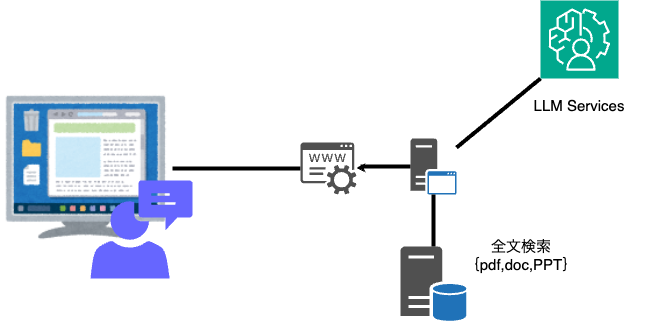

- RAG 検索の仕組みと活用方法

RAG(Retrieval-Augmented Generation)検索は、外部データベースから情報を取得し、生成AIと組み合わせて高精度な回答を提供する技術です。具体的には、自然言語での質問に対して、まず関連性の高い情報をデータベースから検索し、次にその情報を基にAIが回答を生成します。これにより、最新かつ正確な情報を含んだ応答が可能となり、社内のナレッジベース検索やFAQシステムに効果的に活用できます。

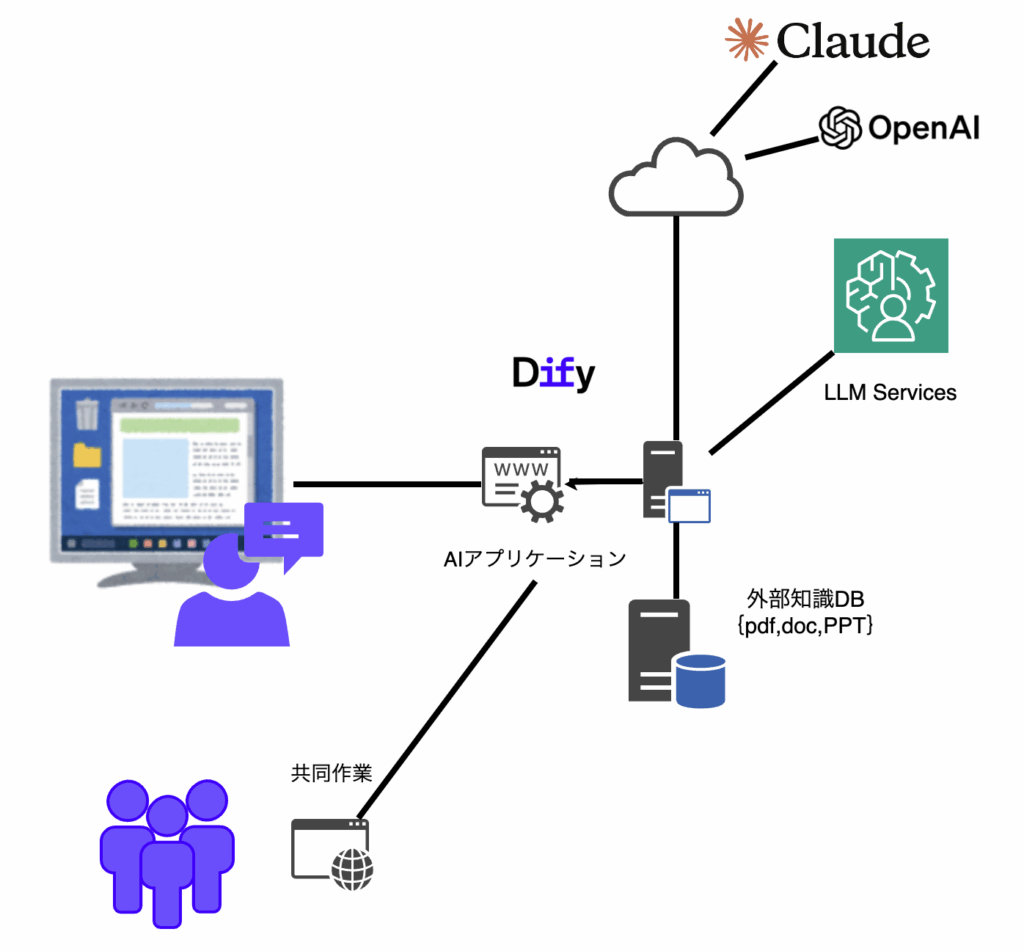

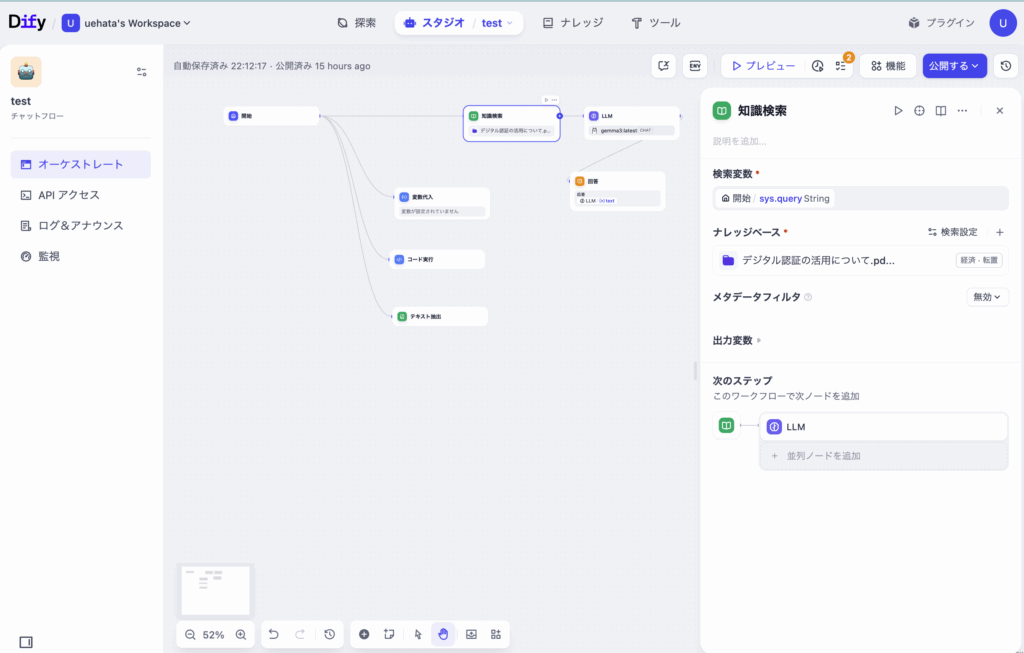

- Dify を活用した社内向け AI アプリの構築

Difyは、AIアプリケーションの開発と管理を効率化するためのプラットフォームです。社内システムでは、Difyを活用してAIモデルのデプロイ、チューニング、モニタリングを簡略化しています。導入方法としては、初期設定でAPIキーを登録し、必要なモデルを選択してカスタマイズします。使い方としては、ダッシュボード上でリアルタイムにAIのパフォーマンスを確認しながら、必要に応じてパラメータを調整することが可能です。社内のAI教育システムとして、最強のツールです。

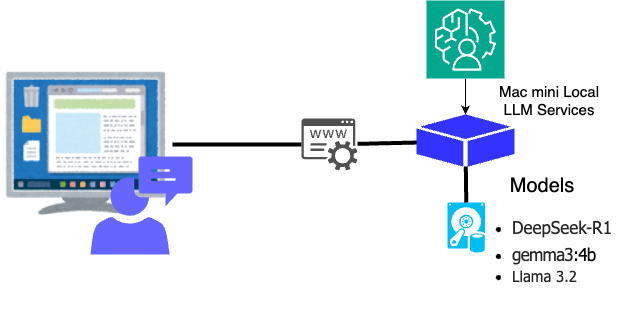

- ローカル LLM(大規模言語モデル)マシンの構築と運用方法

ローカルLLM(大規模言語モデル)環境の構築には、Mac miniを提案しています。Mac miniはコンパクトながら高性能なCPUとGPUを搭載しており、社内でのAIモデルのトレーニングや推論処理に最適です。システム構成としては、Mac mini上にローカルLLMを構築し、社内ネットワークを通じて各アプリケーションと連携することが可能です。このローカルマシン構成により、クラウド依存を減らし、データセキュリティとレスポンス速度の向上に期待できます。

以上の要素を組み合わせることで、効率的かつ安全なAIシステムのローカル運用が可能です。

- QNAPを採用したローカルマシン環境の概要

QNAPとは?

QNAP(Quality Network Appliance Provider)は、主にNAS(ネットワークアタッチトストレージ)デバイスを提供する企業です。QNAPのNASは、データストレージ、バックアップ、ファイル共有、仮想化環境のホスティングなど、多目的に利用されます。

TVS-h674-i5-32GB

| CPU | Intel® Core™ i5-12400 6コア/12スレッド プロセッサ、最大バースト4.4 GHz |

QNAPをローカルマシン環境で採用する理由

- データ共有と管理の効率化:複数のローカルマシン間でデータを簡単に共有。

- 高いセキュリティ:多層防御システムでデータの安全を確保。

- 拡張性:ストレージ容量やアプリケーションを必要に応じて追加可能。

- 仮想化サポート:VMwareやDockerコンテナの実行環境としても利用可能。

ローカルマシン環境での設定例

- ハードウェア構成:

- QNAP NASデバイス(例: TSシリーズ)

- ギガビットイーサネットスイッチ

- クライアントPC(Windows、Mac、Linux)

- ネットワークトポロジー:

- NASをルーターやスイッチに接続し、各ローカルマシンと同一のLAN内に配置。

主な活用シナリオ

- ファイルサーバーとして:社内共有ドライブとしての利用。

- バックアップサーバー:定期的なローカルマシンのバックアップ保存。

- メディアサーバー:PlexやDLNAサーバーでのメディア配信。

- 仮想化プラットフォーム:軽量な仮想マシンやコンテナのホスティング。Linux環境の構築

セキュリティ対策

- アクセス制御:ユーザーごとのアクセス権限の設定。

- 暗号化:データ転送時や保存時の暗号化対応。

- バックアップと冗長化:RAID構成や外部バックアップの設定。

QNAPを採用することで、ローカルマシン環境の効率化と安定性を大きく向上させることができます。